Boostez votre expertise sur dbt, le framework open source incontournable pour transformer vos données en un véritable moteur de croissance pour votre organisation.

Dans les environnements data modernes, la capacité à transformer les données de manière fiable, collaborative et gouvernée est un défi central. dbt (Data Build Tool) s’est imposé comme un outil clé pour répondre à ces enjeux, particulièrement dans des contextes cloud-native et modern data stack.

Dbt, c’est quoi ?

dbt est un framework open-source conçu pour permettre aux équipes data de définir, tester et documenter des transformations de données directement au sein des data warehouses ou lakehouses. Il repose sur un principe clé : la transformation des données doit être gérée comme du code, avec versioning, collaboration, et automatisation dans une CI/CD.

Plutôt que d’exécuter des pipelines ETL traditionnels, dbt se concentre exclusivement sur la partie T (transformation) du ELT, exploitant directement la puissance de calcul des data warehouses.

Comment dbt s’exécute-t-il ?

L’exécution de dbt repose sur un moteur qui :

- Lit les modèles SQL définis par les data engineers.

- Résout les dépendances entre les modèles.

- Génère les requêtes SQL finales.

- Exécute les transformations directement dans le data warehouse ou lakehouse cible.

Modes d’exécution

- En local, depuis l’environnement du développeur (dbt CLI).

- Via dbt Cloud, une plateforme SaaS qui orchestre et planifie les exécutions.

- Intégré dans des pipelines CI/CD (GitHub Actions, GitLab CI, Azure DevOps, etc.).

Orchestration

dbt ne fait pas d’orchestration de workflows complets (ingestion, ML, etc.), mais il s’intègre avec des orchestrateurs comme Airflow, Kestra ou Dagster, pour s’insérer dans des pipelines plus larges.

Les forces de dbt

1. SQL Centric

Les modèles sont définis en SQL, un langage maîtrisé par la majorité des data engineers et analysts. dbt introduit une approche modulaire, où chaque modèle peut être testé, documenté et versionné.

2. Gestion des dépendances

Les modèles peuvent se référencer entre eux via des macros, créant automatiquement un DAG (Directed Acyclic Graph) de transformation. Cela permet de visualiser la chaîne complète de traitement des données.

3. Tests et documentation automatisés

- dbt permet d’écrire des tests unitaires (unicité, non-nullité, relations référentielles).

- Il génère automatiquement une documentation complète avec schémas de dépendances.

- La doc est servie via une interface web conviviale, utile aux data engineers comme aux métiers.

4. Collaboration et CI/CD

- Chaque modèle SQL est versionné dans un repository Git.

- Les workflows de merge request incluent la validation automatique (tests, linting SQL, génération de doc).

- dbt encourage les bonnes pratiques de DataOps.

5. Multi-cloud et multi-technologies

dbt supporte nativement plusieurs data warehouses et lakehouses, ce qui le rend très flexible:

Technologie | Supportée ? |

|---|---|

BigQuery | ✅ |

Snowflake | ✅ |

Redshift | ✅ |

Databricks | ✅ |

Azure Synapse | ✅ (via plugins) |

PostgreSQL | ✅ |

DuckDB | ✅ |

Trino | ✅ |

Clickhouse | ✅ (via plugins) |

Faiblesses et limites

- Focus exclusif sur la transformation : dbt ne gère ni l’ingestion des données, ni leur orchestration globale. Il intervient uniquement après que les données sont disponibles dans le data warehouse, ce qui impose souvent de l’intégrer dans des flux plus larges (avec NiFi, Airbyte, Fivetran, etc.).

- SQL uniquement : Bien que dbt soit un outil SQL-first, certains cas d’usage (transformation complexes, machine learning) nécessitent des langages plus riches (Python, Scala). Cela reste limité dans dbt (sauf en Databricks via dbt Python models).

- Gestion de la complexité : Dans les grandes organisations, la multiplication des modèles et des références croisées peut aboutir à une forte complexité (modèles en cascade, performance dégradée). Cela nécessite une gouvernance stricte.

- Coût des requêtes : En exécutant toutes les transformations directement dans le warehouse, dbt peut faire exploser les coûts si les modèles sont mal optimisés, surtout sur Snowflake ou BigQuery.

Intérêts stratégiques pour les DSI et CDO

1. Alignement business & technique

dbt favorise un modèle où les métiers (analystes) et les équipes data engineering partagent les mêmes outils et les mêmes modèles SQL, créant une traçabilité directe entre les sources brutes et les KPIs exposés dans les dashboards.

2. Documentation et gouvernance

- Documentation centralisée.

- Traçabilité complète des transformations.

- Facilité d’audit et de contrôle.

3. Agilité et time-to-value

dbt accélère la mise en production de nouveaux indicateurs, grâce à son approche modulaire et sa forte intégration avec les workflows DevOps existants.

Exemple de cas d’usage : Reporting financier dans une ETI

Dans une entreprise multi-filiales, dbt pourrait être utilisé pour :

- Charger les données comptables brutes dans BigQuery.

- Définir une première couche de modèles dbt pour normaliser les plans comptables.

- Ajouter une couche de modèles pour agréger les dépenses et recettes par centre de coût.

- Tester automatiquement la cohérence des agrégations.

- Générer la documentation complète accessible aux contrôleurs de gestion.

- Publier les tables finales directement consommables par PowerBI ou Looker.

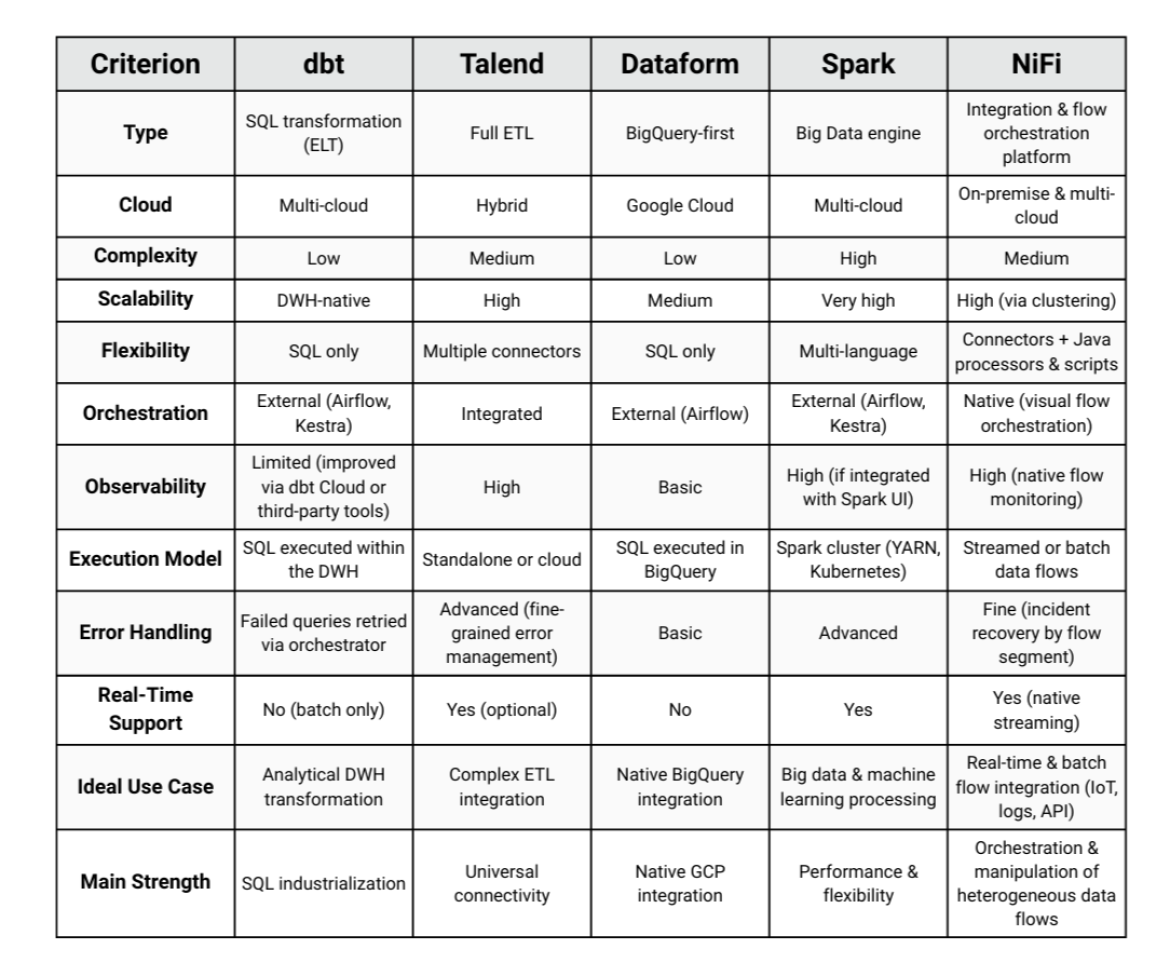

Quelques comparatifs intéressants

Il est important de bien comprendre qu’on ne compare pas toujours des outils strictement équivalents.

Pourquoi ?

dbt est focalisé sur la transformation SQL et la gestion de la couche "T" dans le ELT. Comparer dbt à une solution d’orchestration complète (comme Airflow, Dagster ou Kestra) ou à un ETL (comme Talend ou nifi) n’a pas forcément de sens. Mais certains critères sont tout de même comparables entre ces solutions.

Il existe peu de benchmarks stricts de performance comparant dbt à d’autres outils, car :

- dbt exécute du SQL directement dans le data warehouse.

- La performance dépend du moteur sous-jacent (BigQuery, Snowflake…).

Cependant, certains tests montrent que :

- dbt est aussi performant que les requêtes SQL manuelles, car il n’ajoute aucune couche intermédiaire.

- Sur de gros volumes (1+ To), dbt reste limité par la capacité du data warehouse. Si le DWH est mal configuré, dbt ne pourra pas compenser (alors que Spark peut partitionner intelligemment).

Si votre architecture cible est une Modern Data Stack (Snowflake, BigQuery, Redshift), dbt est presque incontournable pour sa simplicité, sa compatibilité avec les process DataOps, et sa proximité avec les pratiques d’ingénierie logicielle.

En revanche, pour des environnements multi-sources complexes, des besoins temps réel ou des cas Big Data avancés, il faut souvent le combiner avec des orchestrateurs (Airflow, Kestra), des outils d’ingestion (Talend, NiFi) et des moteurs analytiques massivement parallèles (Spark).

Conclusion

dbt est bien plus qu’un simple outil de transformation SQL. Il s’impose comme un standard dans les environnements data modernes, en apportant à la fois une discipline d’ingénierie logicielle et une proximité avec les métiers, ce qui en fait un levier clé pour les DSI et CDO en quête de gouvernance et d’agilité.

Toutefois, il ne couvre qu’une partie du pipeline data (le T de ELT) et doit s’intégrer dans une chaîne plus large, orchestrée par des outils comme Airflow, Kestra ou Dagster, et alimentée par des solutions d’ingestion comme talend ou NiFi.

Contactez-nous dès aujourd’hui et transformez vos projets data pour accélérer votre transformation numérique ou téléchargez notre dernier livre blanc, "La liste ultime pour construire une application d’IA open source".